大规模AI网络的创建与使用成本正在爆炸式增长:Open.AI的GPT-3模型使用数千个GPU经历数周才完成训练,总成本超过1200万美元。但IBM坚信深入的研究与探索有望解决这一困境。成立于2019年5月的IBM Research AI研究中心就定下了坚定目标,计划在未来十年内将AI性能与能效提升1000倍。而在两年多的发展之后,我们不妨共同了解这处中心的实际进展与未来发展路线图。

简而言之,从AI研究中心的早期技术成果来看,千倍增长的积极目标似乎并非纸上谈兵。有些人认为“IBM已经脱离了硬件业务”,他们显然并不了解蓝色巨人付出的持续努力。如今,全球投入数十亿美元打造更强大的AI平台,而IBM的AI芯片正在其中牢牢把握着领先优势。

目标与成就

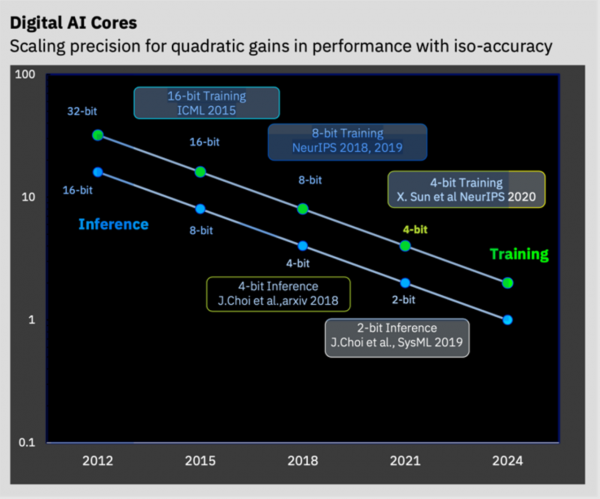

IBM AI硬件中心的研究重点共有四项:加速数字AI、模拟AI、异构芯片集成以及面向最终用户的AI测试平台。其中数字AI项目已经成功将训练精度降低至4位、推理降低至2位,同时继续保持可接受的准确率水平。与之前的16位浮点运算相比,第三代IBM AI核心实现了近8倍的性能提升,也让IBM成为AI领域的第一家IP技术许可商、开始为以色列初创企业NeuReality提供支持。AI硬件中心的产权成果与AI核心还将亮相于即将推出的IBM Z系统Telum处理器当中。最终用户AI测试平台则开始提供用于模拟内存内计算的Analog Composer体验,并希望在不久的将来通过各类基础设施(包括针对AI工作负载进行优化的AiMOS超级计算机)全面放开数字化低精度硬件的访问通道。

IBM Research为AI加速技术设下的一系列发展轨迹。

除了量化技术之外,该团队还一直在探索如何将AI模型中的数据稀疏性(即粗/细粒度与随机/结构化)与低精度极端量化思路结合起来。IBM研究人员认为,如果未来三年内能够把这些技术成功融汇为一体,那么性能水平还将再提高10倍。

在模拟AI领域,IBM定下的发展目标是短期内提供推理技术、长期提供训练技术;同时推动内存内数据处理能力,目标是将现有架构的每瓦性能水平再提高5到10倍。虽然其他厂商也已经在模拟内存推理处理方面取得不小的进展,但IBM这种以模拟方式解决深度神经网络训练中大量算力及功耗需求的努力仍然堪称业界唯一。

除了关注现有模拟AI设备之外,IBM团队还在研究各类内存技术,包括PCM、RRAM及ECRAM,希望借此达成百倍效率提升的目标。具备模拟计算功能的下一代AI核心也可以采用3D堆叠结构实现相应的带宽改进。总而言之,一系列近似计算创新成果的加入,有望大大超越IBM定下的每年2.5倍的增效目标。

研究中心还在积极探索可行的架构设计与封装技术。研究中心的科学家们希望通过更高的并行性利用率(管道与模型)提高资源效率,并增强片上网络(NOC)架构以提供底层支持。

目前研究团队正在考虑的另一个核心问题,在于模型大小与内存影响。虽然朝着模型并行性探索似乎会是正确方向,但现有设计明显还不够完善。当前的推荐类模型特别占用内存,因此大多数电子商务站点仍在使用CPU来处理这类工作负载,其中单是嵌入表就可能需要占用10 GB甚至上百GB的内存。先不说这样的数据量已经超过了现有高带宽内存设备的容量,即使后续HBM内存容量能够存放一切,由此引发的高成本与软件复杂性仍然客观存在。要解决内存问题,可能的解决方案是将SRAM与DRAM同AI核心及SoC以3D形式堆叠起来。此外,张量压缩也有助于缩小数据体积。

在软件方面,IBM正在投资改进IBM DeepTools编译器堆栈,希望支持包含众多先进编译器优化成果的下一代多核心AI硬件。IBM希望利用面向运行时与offloads卸载容量的通用轻量化API,同时支持多种框架(TensorFlow、PyTorch等)与ONNX模型。

除了努力实现AI可解释性外,IBM还在考虑构建面向图神经网络(GNN)、逻辑神经网络(LNN)、神经符号AI以及其他多种新兴AI方法的推理系统。最后,研究人员还在持续关注AI加速器的安全性问题,希望能在关键任务应用程序中获得可靠的安全表现。这样AI芯片与系统不仅能够实现端到端加密安全,同时也有助于预防针对AI系统的侧信道攻击。

总结

IBM Research AI硬件中心铺开了自己的积极探索计划,不仅致力于提升原始性能,还在着力提升能源效率、模型可扩展性、新应用领域、安全性与可解释性等。可以肯定的是,这是一片亟待探索的蓝海;而蓝色巨人在原有成果的基础上,不断推进着更伟大的价值实现与创新规划。预祝IBM能够在这场攻坚战中高奏凯歌,帮助更多企业站在巨人的肩膀上完成技术变革。